diff --git a/chapters/de/_toctree.yml b/chapters/de/_toctree.yml

index 0aae386ae..7227717ef 100644

--- a/chapters/de/_toctree.yml

+++ b/chapters/de/_toctree.yml

@@ -20,6 +20,15 @@

title: Quiz am Ende des Kapitels

quiz: 3

+- title: 4. Teilen von Modellen und Tokenizers

+ sections:

+ - local: chapter4/1

+ title: Der Hugging Face Hub

+ - local: chapter4/2

+ title: Verwendung vortrainierter Modelle

+ - local: chapter4/3

+ title: Vortrainierte Modelle teilen

+

- title: Wörterverzeichnis

sections:

- local: glossary/1

diff --git a/chapters/de/chapter4/1.mdx b/chapters/de/chapter4/1.mdx

new file mode 100644

index 000000000..d0130e5f3

--- /dev/null

+++ b/chapters/de/chapter4/1.mdx

@@ -0,0 +1,18 @@

+# Der Hugging Face Hub

+

+Der [Hugging Face Hub](https://huggingface.co/) –- unsere Hauptwebseite –- ist eine zentrale Platform, wo Nutzer*innen "state-of-the-art" Modelle und Datensätze entdecken, benutzen und dazu beitragen können. Eine große Vielfalt an Modellen steht öffentlich zur Verfügung auf der Platform – insgesamt mehr als 10000 Modelle. In diesem Kapitel fokusieren wir uns auf die Modelle und die Datensätze werden wir uns im Kapitel 5 anschauen.

+

+Die Modelle auf dem Hub sind nicht auf 🤗 Transformers bzw. NLP eingeschränkt.

+Es gibt Modelle von [Flair](https://github.com/flairNLP/flair) und [AllenNLP](https://github.com/allenai/allennlp) für NLP, [Asteroid](https://github.com/asteroid-team/asteroid) und [pyannote](https://github.com/pyannote/pyannote-audio) für Spracherkennung, und [timm](https://github.com/rwightman/pytorch-image-models) für Computer Vision, um ein paar Beispiele zu nennen.

+

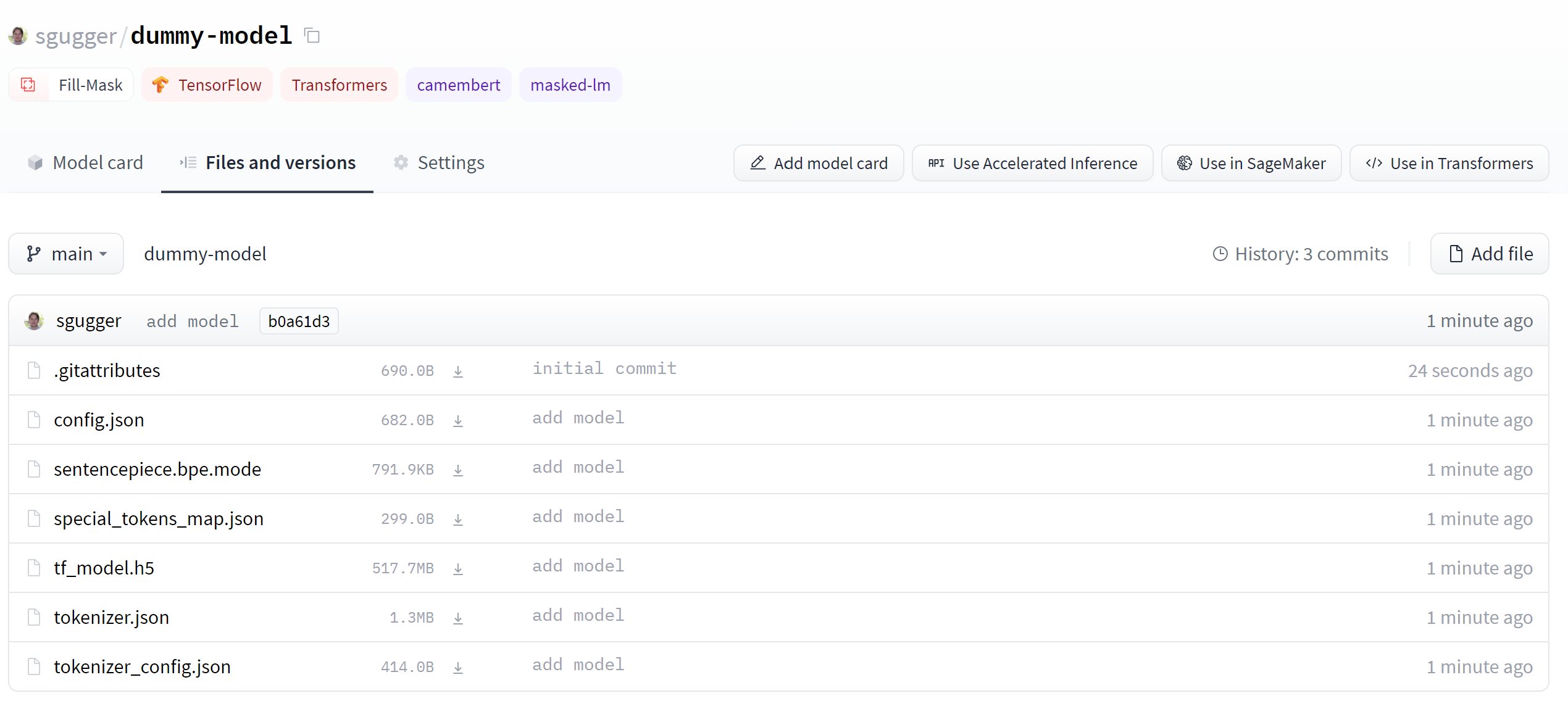

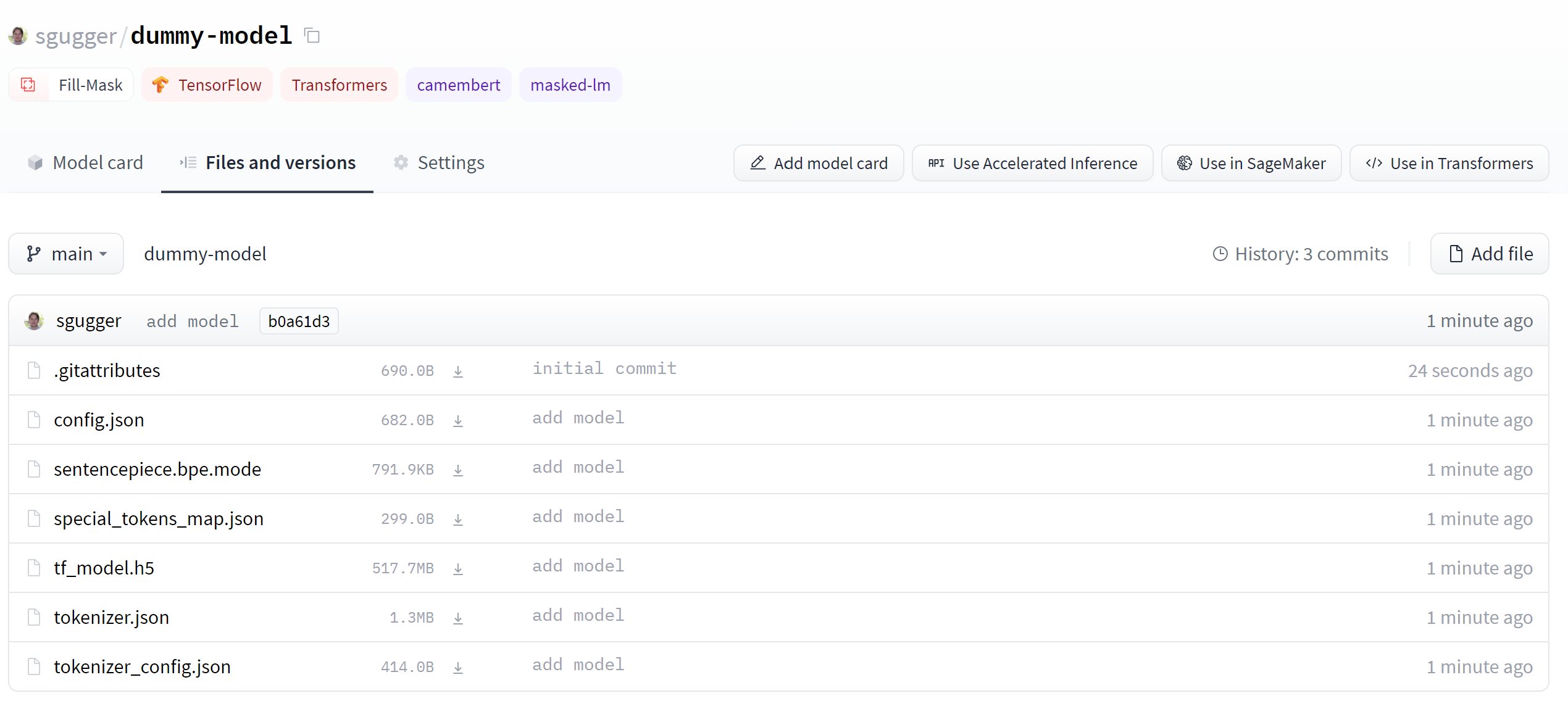

+Jedes Modell wird als Git-Repository gehosted, was Versionierung und Reproduzierbarkeit ermöglicht. Durch das Teilen eines Modells wird dieses der Community zur Verfügung gestellt. Somit wird das Teilen und die Anwendung vom Modell einfacher und jede/r hat die Möglichkeit, das Modell zu Verwenden, ohne es selbst trainieren zu müssen.

+

+Dazu löst das Teilen eines Modells auf dem Hub automatisch das Deployment einer Hosted-Inferenz-API für das Modell aus. Jede/r in der Communinity kann das Modell direkt auf der Modellsseite mit benutzerdefinierten Inputs und passenden Widgets ausprobieren.

+

+Das Beste ist, dass sowohl das Teilen als auch das Nutzen von öffentlichen Modellen auf dem Hub völlig kostenlos erfolgt! [Bezahlte Pläne](https://huggingface.co/pricing) gibt es auch, falls du Modelle privat teilen möchtest.

+

+Das folgende Video zeigt, wie man auf dem Hub navigieren kann.

+

+

+

+Ein huggingface.co Account ist für den folgenden Teil erforderlich, da wir Repositories auf dem Hugging Face Hub erstellen und verwalten werden: [Account erstellen](https://huggingface.co/join)

diff --git a/chapters/de/chapter4/2.mdx b/chapters/de/chapter4/2.mdx

new file mode 100644

index 000000000..0b20fe1d9

--- /dev/null

+++ b/chapters/de/chapter4/2.mdx

@@ -0,0 +1,96 @@

+

+

+# Verwendung vortrainierter Modelle

+

+{#if fw === 'pt'}

+

+

+

+{:else}

+

+

+

+{/if}

+

+

+Der Model Hub erleichtert das Auswählen des passenden Modells, sodass es von downstream Libraries mit wenigen Codezeilen benutzt werden kann. Lass uns anschauen, wie genau man solche Modelle verwendet und wie man der Communinity zurück beitragen kann.

+

+Nehmen wir an, wir suchen nach einem französichbasierten Modell, das die "mask filling" Aufgabe kann.

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+ +

+