diff --git a/chapters/de/_toctree.yml b/chapters/de/_toctree.yml

index 7227717ef..c43192ca8 100644

--- a/chapters/de/_toctree.yml

+++ b/chapters/de/_toctree.yml

@@ -3,6 +3,30 @@

- local: chapter0/1

title: Einführung

+- title: 1. Transformer-Modelle

+ sections:

+ - local: chapter1/1

+ title: Einführung

+ - local: chapter1/2

+ title: Natural Language Processing

+ - local: chapter1/3

+ title: Transformer-Modelle - wozu sind sie imstande?

+ - local: chapter1/4

+ title: Wie funktionieren Transformer-Modelle?

+ - local: chapter1/5

+ title: Encoder-Modelle

+ - local: chapter1/6

+ title: Decoder-Modelle

+ - local: chapter1/7

+ title: Sequence-to-Sequence-Modelle

+ - local: chapter1/8

+ title: Bias und Einschränkungen

+ - local: chapter1/9

+ title: Zusammenfassung

+ - local: chapter1/10

+ title: Quiz am Ende des Kapitels

+ quiz: 1

+

- title: 3. Fine-tuning von vortrainierten Modellen

sections:

- local: chapter3/1

diff --git a/chapters/de/chapter1/1.mdx b/chapters/de/chapter1/1.mdx

new file mode 100644

index 000000000..14e19601c

--- /dev/null

+++ b/chapters/de/chapter1/1.mdx

@@ -0,0 +1,102 @@

+# Einführung

+

+

+

+## Willkommen zum 🤗 Kurs!

+

+

+

+In diesem Kurs lernst du verschiedene Teilbereiche der maschinellen Verarbeitung natürlicher Sprache (engl. Natural Language Processing, NLP) - im Deutschen auch als Maschinelle Sprachverarbeitung oder Computerlinguistik (CL) bezeichnet - unter Verwendung der Bibliotheken des Ökosystems von [Hugging Face](https://huggingface.co/) kennen: die [🤗 Transformers-](https://github.com/huggingface/transformers), die [🤗 Datasets-](https://github.com/huggingface/datasets), die [🤗 Tokenizers-](https://github.com/huggingface/tokenizers) sowie die [🤗 Accelerate-Bibliotheken](https://github.com/huggingface/accelerate) als auch der [Hugging Face Hub](https://huggingface.co/models). Der Kurs ist komplett kostenlos und frei von Werbung.

+

+

+## Was erwartet dich?

+

+Hier ein kurzer Überblick über den Kurs:

+

+

+

+

+

+

+Wenn du nach dem Kurs noch weiter üben möchtest, steht dir in den Foren eine Liste mit [Projektideen](https://discuss.huggingface.co/c/course/course-event/25) zur Verfügung.

+

+- **Wo finde ich den Code für den Kurs?**

+In jedem Abschnitt kannst du auf das oben auf der Seite befindliche Banner klicken, um den Code entweder in Google Colab oder in Amazon SageMaker Studio Lab auszuführen:

+

+

+

+Wenn du nach dem Kurs noch weiter üben möchtest, steht dir in den Foren eine Liste mit [Projektideen](https://discuss.huggingface.co/c/course/course-event/25) zur Verfügung.

+

+- **Wo finde ich den Code für den Kurs?**

+In jedem Abschnitt kannst du auf das oben auf der Seite befindliche Banner klicken, um den Code entweder in Google Colab oder in Amazon SageMaker Studio Lab auszuführen:

+

+ +

+Die Jupyter-Notebooks, die den gesamten Code des Kurses enthalten, befinden sich im [`huggingface/notebooks`-Repo](https://github.com/huggingface/notebooks). Wenn du sie lokal aufsetzen möchtest, schau dir die Anweisungen im [`course`-Repository](https://github.com/huggingface/course#-jupyter-notebooks) auf GitHub an.

+

+

+- **Wie kann ich etwas zum Kurs beitragen?**

+Es gibt mehrere Möglichkeiten, zum Kurs beizutragen! Wenn du einen Tippfehler oder einen Fehler entdeckst, eröffne bitte ein Issue in dem [`course`-Repository](https://github.com/huggingface/course). Wenn du uns dabei unterstützen möchtest, den Kurs in deine Muttersprache zu übersetzen, sieh dir bitte die [Anleitung](https://github.com/huggingface/course#translating-the-course-into-your-language) an.

+

+- **Welche Entscheidungen wurden bei den einzelnen Übersetzungen getroffen?**

+Für jede Übersetzung gibt es ein Glossar und die Datei `TRANSLATING.txt`, in der die gewählten Fachtermini usw. festgehalten sind. Ein Beispiel für die deutsche Fassung findest du [hier](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Kann ich diesen Kurs auch an anderer Stelle verwenden?**

+Ja, natürlich! Der Kurs ist unter der permissiven [Apache-2-Lizenz](https://www.apache.org/licenses/LICENSE-2.0.html) veröffentlicht. Das bedeutet, dass du den Kurs in angemessener Weise erwähnen, einen Verweis zur Lizenz angeben und darauf hinweisen musst, wenn du Änderungen vorgenommen hast. Du kannst dies in jeder angemessenen Weise tun, allerdings nicht in einer Weise, die den Eindruck erweckt, dass der Lizenzgeber dich oder deine Nutzung unterstützt. Wenn du den Kurs zitieren möchtest, verwende bitte den folgenden BibTeX-Eintrag:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed ]"

+}

+```

+

+Bist du bereit, loszulegen? In diesem Kapitel lernst du

+* wie man die Funktion `pipeline()` benutzt, um computerlinguistische Aufgaben wie Textgenerierung und Klassifizierung zu lösen,

+* mehr über die Transformer-Architektur und

+* wie zwischen Encoder-, Decoder- und Encoder-Decoder-basierten Architekturen und -Anwendungsfällen unterschieden werden kann.

diff --git a/chapters/de/chapter1/10.mdx b/chapters/de/chapter1/10.mdx

new file mode 100644

index 000000000..0d6054011

--- /dev/null

+++ b/chapters/de/chapter1/10.mdx

@@ -0,0 +1,260 @@

+

+

+

+

+

+# Quiz am Ende des Kapitels

+

+In diesem Kapitel hast du viel gelernt! Mach dir keine Sorgen, wenn du noch nicht alle Einzelheiten verstanden hast. In den nächsten Kapiteln wirst du mehr darüber erfahren, wie die Dinge im Einzelnen funktionieren.

+

+Doch zuerst wollen wir noch testen, was du in diesem Kapitel gelernt hast!

+

+

+### 1. Erkunde den Hub und suche nach dem Checkpoint `roberta-large-mnli`. Welche Aufgabe unterstützt er?

+

+

+roberta-large-mnli nach."

+ },

+ {

+ text: "Text Classification (Textklassifizierung)",

+ explain: "Genauer gesagt, wird klassifiziert, ob zwei Sätze hinsichtlich dreier Labels (Widerspruch (engl. Contradiction), Neutral, Konsequenz (engl. Entailment)) logisch miteinander verbunden sind - eine Aufgabe, die auch als Natural Language Inference bezeichnet wird.",

+ correct: true

+ },

+ {

+ text: "Text Generation (Textgenerierung)",

+ explain: "Sieh nochmal auf der Seite des Modells roberta-large-mnli nach."

+ }

+ ]}

+/>

+

+### 2. Was gibt der folgende Code zurück?

+

+```py

+from transformers import pipeline

+

+ner = pipeline("ner", grouped_entities=True)

+ner("My name is Sylvain and I work at Hugging Face in Brooklyn.")

+```

+

+sentiment-analysis-Pipeline verwenden."

+ },

+ {

+ text: "Er wird einen generierten Text zurückgeben, der diesen Satz vervollständigt.",

+ explain: "Das ist nicht richtig - dafür müsstest du eine

+

+Die Jupyter-Notebooks, die den gesamten Code des Kurses enthalten, befinden sich im [`huggingface/notebooks`-Repo](https://github.com/huggingface/notebooks). Wenn du sie lokal aufsetzen möchtest, schau dir die Anweisungen im [`course`-Repository](https://github.com/huggingface/course#-jupyter-notebooks) auf GitHub an.

+

+

+- **Wie kann ich etwas zum Kurs beitragen?**

+Es gibt mehrere Möglichkeiten, zum Kurs beizutragen! Wenn du einen Tippfehler oder einen Fehler entdeckst, eröffne bitte ein Issue in dem [`course`-Repository](https://github.com/huggingface/course). Wenn du uns dabei unterstützen möchtest, den Kurs in deine Muttersprache zu übersetzen, sieh dir bitte die [Anleitung](https://github.com/huggingface/course#translating-the-course-into-your-language) an.

+

+- **Welche Entscheidungen wurden bei den einzelnen Übersetzungen getroffen?**

+Für jede Übersetzung gibt es ein Glossar und die Datei `TRANSLATING.txt`, in der die gewählten Fachtermini usw. festgehalten sind. Ein Beispiel für die deutsche Fassung findest du [hier](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Kann ich diesen Kurs auch an anderer Stelle verwenden?**

+Ja, natürlich! Der Kurs ist unter der permissiven [Apache-2-Lizenz](https://www.apache.org/licenses/LICENSE-2.0.html) veröffentlicht. Das bedeutet, dass du den Kurs in angemessener Weise erwähnen, einen Verweis zur Lizenz angeben und darauf hinweisen musst, wenn du Änderungen vorgenommen hast. Du kannst dies in jeder angemessenen Weise tun, allerdings nicht in einer Weise, die den Eindruck erweckt, dass der Lizenzgeber dich oder deine Nutzung unterstützt. Wenn du den Kurs zitieren möchtest, verwende bitte den folgenden BibTeX-Eintrag:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed ]"

+}

+```

+

+Bist du bereit, loszulegen? In diesem Kapitel lernst du

+* wie man die Funktion `pipeline()` benutzt, um computerlinguistische Aufgaben wie Textgenerierung und Klassifizierung zu lösen,

+* mehr über die Transformer-Architektur und

+* wie zwischen Encoder-, Decoder- und Encoder-Decoder-basierten Architekturen und -Anwendungsfällen unterschieden werden kann.

diff --git a/chapters/de/chapter1/10.mdx b/chapters/de/chapter1/10.mdx

new file mode 100644

index 000000000..0d6054011

--- /dev/null

+++ b/chapters/de/chapter1/10.mdx

@@ -0,0 +1,260 @@

+

+

+

+

+

+# Quiz am Ende des Kapitels

+

+In diesem Kapitel hast du viel gelernt! Mach dir keine Sorgen, wenn du noch nicht alle Einzelheiten verstanden hast. In den nächsten Kapiteln wirst du mehr darüber erfahren, wie die Dinge im Einzelnen funktionieren.

+

+Doch zuerst wollen wir noch testen, was du in diesem Kapitel gelernt hast!

+

+

+### 1. Erkunde den Hub und suche nach dem Checkpoint `roberta-large-mnli`. Welche Aufgabe unterstützt er?

+

+

+roberta-large-mnli nach."

+ },

+ {

+ text: "Text Classification (Textklassifizierung)",

+ explain: "Genauer gesagt, wird klassifiziert, ob zwei Sätze hinsichtlich dreier Labels (Widerspruch (engl. Contradiction), Neutral, Konsequenz (engl. Entailment)) logisch miteinander verbunden sind - eine Aufgabe, die auch als Natural Language Inference bezeichnet wird.",

+ correct: true

+ },

+ {

+ text: "Text Generation (Textgenerierung)",

+ explain: "Sieh nochmal auf der Seite des Modells roberta-large-mnli nach."

+ }

+ ]}

+/>

+

+### 2. Was gibt der folgende Code zurück?

+

+```py

+from transformers import pipeline

+

+ner = pipeline("ner", grouped_entities=True)

+ner("My name is Sylvain and I work at Hugging Face in Brooklyn.")

+```

+

+sentiment-analysis-Pipeline verwenden."

+ },

+ {

+ text: "Er wird einen generierten Text zurückgeben, der diesen Satz vervollständigt.",

+ explain: "Das ist nicht richtig - dafür müsstest du eine text-generation-Pipeline verwenden.",

+ },

+ {

+ text: "Er gibt Begriffe zurück, die für Personen, Organisationen oder Orte stehen.",

+ explain: "Außerdem werden mit grouped_entities=True die Wörter, die zur selben Entität gehören, gruppiert, wie z. B. \"Hugging Face\".",

+ correct: true

+ }

+ ]}

+/>

+

+### 3. Wodurch müsste ... in diesem Codebeispiel ersetzt werden?

+

+```py

+from transformers import pipeline

+

+filler = pipeline("fill-mask", model="bert-base-cased")

+result = filler("...")

+```

+

+ has been waiting for you.",

+ explain: "Das stimmt nicht. Schau dir die bert-base-cased-Übersichtsseite des Modells an und versuche, deinen Fehler zu entdecken."

+ },

+ {

+ text: "This [MASK] has been waiting for you.",

+ explain: "Richtig! Der Mask Token dieses Modells ist [MASK].",

+ correct: true

+ },

+ {

+ text: "This man has been waiting for you.",

+ explain: "Leider falsch. Diese Pipeline füllt maskierte Wörter auf, also braucht sie irgendwo einen Mask Token."

+ }

+ ]}

+/>

+

+### 4. Warum wird dieser Code nicht funktionieren?

+

+```py

+from transformers import pipeline

+

+classifier = pipeline("zero-shot-classification")

+result = classifier("This is a course about the Transformers library")

+```

+

+candidate_labels=[...] enthalten.",

+ correct: true

+ },

+ {

+ text: "Diese Pipeline erfordert mehrere Sätze, nicht nur einen.",

+ explain: "Das ist falsch - obwohl diese Pipeline, wenn sie korrekt verwendet wird, eine Liste von Sätzen verarbeiten kann (wie alle anderen Pipelines)."

+ },

+ {

+ text: "Die 🤗 Transformers-Bibliothek funktioniert wie immer nicht.",

+ explain: "Zu dieser Antwort erübrigt sich jeder Kommentar!"

+ },

+ {

+ text: "Diese Pipeline erfordert längere Inputs; diese hier sind zu kurz.",

+ explain: "Das ist falsch. Übrigens wird ein sehr langer Text bei der Verarbeitung durch diese Pipeline gestutzt (engl. truncated) bzw. gekürzt."

+ }

+ ]}

+/>

+

+### 5. Was bedeutet der Begriff "Transfer Learning"?

+

+

+

+### 6. Richtig oder falsch? Ein Sprachmodell benötigt im Rahmen des Pretraining in der Regel keine Labels.

+

+

+selbstüberwacht (engl. self-supervised), d. h. die Labels werden automatisch aus den Inputs erstellt (wie z. B. die Vorhersage des nächsten Wortes oder das Auffüllen einiger maskierter Wörter).",

+ correct: true

+ },

+ {

+ text: "Falsch",

+ explain: "Das ist nicht die richtige Antwort."

+ }

+ ]}

+/>

+

+### 7. Wähle den Satz aus, der die Begriffe "Modell", "Architektur" und "Gewichte" bzw. "Gewichtung" am besten beschreibt.

+

+

+

+

+### 8. Welche dieser Modelle würdest du nutzen, um einen Prompt bzw. Text-Input durch einen generierten Text vervollständigen zu lassen?

+

+

+

+### 9. Welche dieser Modelle würdest du für die Zusammenfassung von Texten verwenden?

+

+

+

+### 10. Welche Art von Modellen würdest du verwenden, um Text-Inputs entsprechend bestimmter Labels zu klassifizieren?

+

+

+

+### 11. Welche mögliche Ursache kann eine vom Modell zu beobachtende Voreingenommenheit (Bias) haben?

+

+

diff --git a/chapters/de/chapter1/2.mdx b/chapters/de/chapter1/2.mdx

new file mode 100644

index 000000000..9f36f8315

--- /dev/null

+++ b/chapters/de/chapter1/2.mdx

@@ -0,0 +1,26 @@

+# Computerlinguistik

+

+

+

+Bevor wir uns mit Transformer-Modellen beschäftigen, wollen wir dir einen kurzen Überblick darüber geben, was Computerlinguistik (engl. Natural Language Processing, NLP) ist und welche Gründe es gibt, sich damit zu befassen.

+

+## Was ist Computerlinguistik (CL)?

+

+CL ist ein Bereich der Linguistik und des Maschinellen Lernens (engl. Machine Learning, ML), der sich darauf konzentriert, alle mit menschlicher Sprache zusammenhängenden Dinge zu verstehen. Das Ziel bei CL-Aufgabenstellungen (engl. Tasks) ist es, nicht nur einzelne Wörter zu verstehen, sondern auch den Kontext dieser Wörter zu erfassen.

+

+Im Folgenden findest du eine Liste der häufigsten CL-Aufgabenstellungen mit jeweils einigen Beispielen:

+

+- **Ganze Sätze klassifizieren**: Die mit einer bestimmten Bewertung verbundene Stimmungslage ermitteln, erkennen, ob eine E-Mail Spam ist, bestimmen, ob ein Satz grammatikalisch korrekt ist oder ob zwei Sätze logisch zusammenhängen oder nicht

+- **Jedes einzelne Wort in einem Satz klassifizieren**: Identifizieren der grammatikalischen Bestandteile eines Satzes (Substantiv, Verb, Adjektiv) oder der benannten Entitäten (Person, Ort, Organisation) (engl. Named Entities)

+- **Generieren von Textinhalten**: Einen Prompt durch einen automatisch generierten Text vervollständigen oder Lücken in einem Text auffüllen, in dem einzelne Wörter maskiert sind

+- **Eine Antwort aus einem Text extrahieren**: Auf Basis einer Frage und eines gegebenen Kontexts die Antwort auf die Frage anhand der im Kontext enthaltenen Informationen extrahieren

+- **Generieren eines neuen Satzes auf Basis eines Input-Textes**: Einen Text in eine andere Sprache automatisch übersetzen, Zusammenfassen eines Textes

+

+Die Computerlinguistik ist jedoch nicht nur auf die Verarbeitung geschriebener Texte beschränkt. Sie stellt sich auch komplexen Herausforderungen in den Bereichen der Spracherkennung (engl. Speech Recognition) und Computer Vision, wie z. B. ein Transkript einer Audioaufnahme zu erstellen oder ein Bild zu beschreiben.

+

+## Warum ist Computerlinguistik so schwierig?

+

+Computer verarbeiten Informationen nicht auf die gleiche Weise wie Menschen. Wenn wir zum Beispiel den Satz "Ich bin hungrig" lesen, können wir seine Bedeutung leicht erfassen. Genauso können wir bei zwei Sätzen wie "Ich habe Hunger" und "Ich bin traurig" leicht feststellen, wie ähnlich sie sind. Für ML-Modelle sind solche Aufgaben schwieriger zu lösen. Der Text muss erst so verarbeitet werden, dass das Modell in der Lage ist, daraus zu lernen. Und weil Sprache komplex ist, müssen wir uns genau überlegen, wie diese Verarbeitung erfolgen sollte. Es wurde eine rege Forschung dazu betrieben, wie Texte repräsentiert werden können. Einige dieser Methoden werden wir uns im nächsten Kapitel ansehen.

diff --git a/chapters/de/chapter1/3.mdx b/chapters/de/chapter1/3.mdx

new file mode 100644

index 000000000..c58ba5d64

--- /dev/null

+++ b/chapters/de/chapter1/3.mdx

@@ -0,0 +1,329 @@

+# Transformer-Modelle - wozu sind sie imstande?

+

+

+

+In diesem Abschnitt schauen wir uns an, was Transformer-Modelle zu leisten imstande sind. Zudem verwenden wir unser erstes Werkzeug aus der 🤗 Transformers-Bibliothek: die Funktion `pipeline()`.

+

+

+👀 Siehst du rechts oben die Schaltfläche Open in Colab? Klicke darauf, um ein Google Colab Notebook, das alle Codebeispiele dieses Abschnitts enthält, zu öffnen. Diese Schaltfläche ist in jedem Abschnitt, der Codebeispiele enthält, zu finden.

+

+Wenn du die Beispiele lieber lokal ausführen möchtest, empfehlen wir dir, einen Blick auf das Kapitel Einrichtung zu werfen.

+

+

+## Transformer-Modelle sind überall anzutreffen!

+

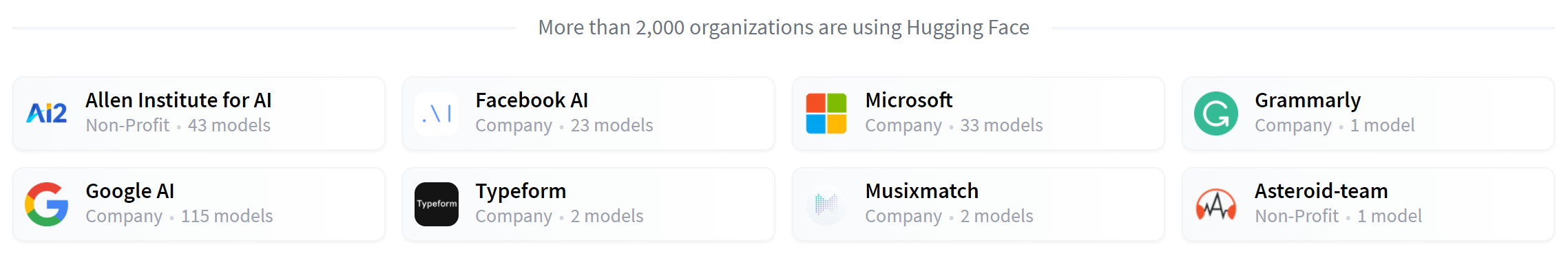

+Transformer-Modelle werden verwendet, um alle Arten von CL-Aufgaben (engl. Tasks) zu lösen, u. a. die im vorherigen Abschnitt genannten. Hier sind einige der Unternehmen und Organisationen, die Hugging-Face- und Transformer-Modelle verwenden und ihre Modelle mit der Community teilen:

+

+ +

+Die [🤗 Transformers-Bibliothek](https://github.com/huggingface/transformers) bietet die Funktionalität, um diese geteilten Modelle zu erstellen und zu nutzen. Der [Model Hub](https://huggingface.co/models) enthält Tausende von vortrainierten Modellen, die jeder herunterladen und nutzen kann. Auch du kannst dort deine eigenen Modelle hochladen!

+

+

+⚠️ Der Hugging Face Hub ist nicht auf Transformer-Modelle beschränkt. Jede bzw. jeder kann die von ihr bzw. ihm gewünschten Arten von Modellen oder Datensätzen teilen! Erstelle ein Konto auf huggingface.co, um alle verfügbaren Features nutzen zu können!

+

+

+Bevor wir uns ansehen, wie Transformer-Modelle im Einzelnen funktionieren, widmen wir uns ein paar Beispielen, die veranschaulichen, wie sie zur Lösung interessanter CL-Problemstellungen eingesetzt werden können.

+

+## Mit Pipelines arbeiten

+

+

+

+Das grundlegendste Objekt in der 🤗 Transformers-Bibliothek ist die `pipeline()`-Funktion. Sie verbindet ein Modell mit den notwendigen Vor- und Nachverarbeitungsschritten (engl. Preprocessing/Postprocessing) und ermöglicht es uns, direkt einen beliebigen Text eingeben zu können und eine Antwort zu erhalten, die verständlich ist:

+

+```python

+from transformers import pipeline

+

+classifier = pipeline("sentiment-analysis")

+classifier("I've been waiting for a HuggingFace course my whole life.")

+```

+

+```python out

+[{'label': 'POSITIVE', 'score': 0.9598047137260437}]

+```

+

+Wir können sogar mehrere Sätze auf einmal übergeben!

+

+```python

+classifier(

+ ["I've been waiting for a HuggingFace course my whole life.", "I hate this so much!"]

+)

+```

+

+```python out

+[{'label': 'POSITIVE', 'score': 0.9598047137260437},

+ {'label': 'NEGATIVE', 'score': 0.9994558095932007}]

+```

+

+In der Voreinstellung wählt diese Pipeline ein bestimmtes vortrainiertes Modell aus, das bereits für die Sentiment-Analyse in englischer Sprache feingetunt wurde. Wenn du das `classifier`-Objekt erstellst, wird das Modell heruntergeladen und zwischengespeichert. Wenn du den Befehl erneut ausführst, wird stattdessen das zwischengespeicherte Modell verwendet und das Modell muss nicht erneut heruntergeladen werden.

+

+Wenn du einen Text an eine Pipeline übergibst, gibt es drei wichtige Schritte:

+

+1. Der Text wird im Rahmen der Vorverarbeitung in ein Format überführt, das das Modell verstehen kann.

+2. Die vorverarbeiteten Inputs bzw. Eingaben werden an das Modell übergeben.

+3. Die Vorhersagen des Modells werden so nachverarbeitet, sodass du sie nutzen kannst.

+

+

+Einige der derzeit [verfügbaren Pipelines](https://huggingface.co/transformers/main_classes/pipelines.html) sind:

+

+- `feature-extraction` (Vektordarstellung eines Textes erhalten)

+- `fill-mask`

+- `ner` (Named Entity Recognition)

+- `question-answering`

+- `sentiment-analysis`

+- `summarization`

+- `text-generation`

+- `translation`

+- `zero-shot-classification`

+

+Werfen wir doch gleich mal einen Blick auf ein paar von ihnen!

+

+## Zero-Shot-Klassifizierung

+

+Beginnen wir mit der recht anspruchsvollen Aufgabe, Texte zu klassifizieren, die noch nicht gelabelt wurden. Dieses Problem tritt häufig in realen Projekten auf, da das Labeln von Texten in der Regel zeitaufwendig ist und Fachwissen erfordert. Für diesen Anwendungsfall ist die Pipeline `zero-shot-classification` sehr vielversprechend: Mit ihr kannst du festlegen, welche Labels für die Klassifizierung verwendet werden sollen, und musst nicht auf die Labels des vortrainierten Modells zurückgreifen. Wie du bereits gesehen hast, kann das Modell einen Satz - entsprechend der beiden Labels - als positiv oder negativ klassifizieren. Es kann den Text aber auch auf der Grundlage einer beliebigen anderen Auswahl an Labels klassifizieren.

+

+```python

+from transformers import pipeline

+

+classifier = pipeline("zero-shot-classification")

+classifier(

+ "This is a course about the Transformers library",

+ candidate_labels=["education", "politics", "business"],

+)

+```

+

+```python out

+{'sequence': 'This is a course about the Transformers library',

+ 'labels': ['education', 'business', 'politics'],

+ 'scores': [0.8445963859558105, 0.111976258456707, 0.043427448719739914]}

+```

+

+Diese Pipeline heißt _zero-shot_, weil du das Modell nicht erst auf deine Daten feintunen musst, ehe du es verwenden kannst. Sie kann direkt die Wahrscheinlichkeiten für jede beliebige von dir vorgegebene Liste von Labels liefern!

+

+

+

+✏️ **Probiere es aus!** Spiel mit deinen eigenen Sequenzen und Labels herum und beobachte, wie sich das Modell verhält.

+

+

+

+

+## Textgenerierung

+

+Sehen wir uns nun an, wie du eine Pipeline verwenden kannst, wenn du einen Text generieren möchtest. Der Grundgedanke dabei ist, dass du einen bestimmten Input (einen sog. Prompt) vorgibst und das Modell diesen automatisch vervollständigt, indem es den restlichen Text generiert. Das ist ähnlich wie die Textvorhersagefunktion, die auf vielen Handys zu finden ist. Die Textgenerierung erfolgt nach dem Zufallsprinzip - daher ist es normal, wenn du nicht die gleichen Ergebnisse wie die unten gezeigten erhältst.

+

+```python

+from transformers import pipeline

+

+generator = pipeline("text-generation")

+generator("In this course, we will teach you how to")

+```

+

+```python out

+[{'generated_text': 'In this course, we will teach you how to understand and use '

+ 'data flow and data interchange when handling user data. We '

+ 'will be working with one or more of the most commonly used '

+ 'data flows — data flows of various types, as seen by the '

+ 'HTTP'}]

+```

+

+Mit dem Argument `num_return_sequences` kannst du steuern, wie viele verschiedene Sequenzen erzeugt werden und mit dem Argument `max_length`, wie lang der Ausgabetext insgesamt sein soll.

+

+

+

+✏️ **Probiere es aus!** Wähle die Argumente `num_return_sequences` und `max_length` so, dass zwei Sätze mit jeweils 15 Wörtern erzeugt werden.

+

+

+

+

+## Verwendung eines beliebigen Modells vom Hub in einer Pipeline

+

+In den vorherigen Beispielen wurde für die jeweilige Aufgabe das voreingestellte Standardmodell verwendet. Du kannst aber auch ein bestimmtes Modell aus dem Hub auswählen und es in einer Pipeline für eine konkrete Aufgabe verwenden - zum Beispiel für die Textgenerierung. Gehe zum [Model Hub](https://huggingface.co/models) und klicke auf der linken Seite unter `Tasks` auf das entsprechende Tag, um dir lediglich die für diese Aufgabenstellung unterstützten Modelle anzeigen zu lassen. Du solltest anschließend auf eine Seite wie [diese](https://huggingface.co/models?pipeline_tag=text-generation) gelangen.

+

+Probieren wir nun das Modell [`distilgpt2`](https://huggingface.co/distilgpt2) aus! So kannst du es mit der gleichen Pipeline wie zuvor laden:

+

+```python

+from transformers import pipeline

+

+generator = pipeline("text-generation", model="distilgpt2")

+generator(

+ "In this course, we will teach you how to",

+ max_length=30,

+ num_return_sequences=2,

+)

+```

+

+```python out

+[{'generated_text': 'In this course, we will teach you how to manipulate the world and '

+ 'move your mental and physical capabilities to your advantage.'},

+ {'generated_text': 'In this course, we will teach you how to become an expert and '

+ 'practice realtime, and with a hands on experience on both real '

+ 'time and real'}]

+```

+

+Du kannst deine Suche nach einem Modell verfeinern, indem du auf eines der `Languages`-Tags klickst und ein Modell auswählst, das Text in einer anderen Sprache generiert. Der Model Hub enthält sogar Checkpoints für mehrsprachige Modelle, die mehrere verschiedene Sprachen unterstützen.

+

+Nachdem du auf ein Modell geklickt und es ausgewählt hast, siehst du, dass es ein Widget gibt, mit dem du es direkt online ausprobieren kannst. Dementsprechend kannst du die Fähigkeiten eines Modells erst schnell testen, bevor du dich dazu entschließt, es herunterzuladen.

+

+

+

+✏️ **Probiere es aus!** Verwende die Filter, um ein Textgenerierungsmodell für eine andere Sprache zu finden. Experimentiere ruhig ein wenig mit dem Widget und verwende das Modell in einer Pipeline!

+

+

+

+### Die Inference API

+

+Alle Modelle können direkt über deinen Browser getestet werden, indem du die Inference API verwendest, die auf der [Webseite von Hugging Face](https://huggingface.co/) verfügbar ist. Auf dieser Seite kannst du direkt mit dem Modell experimentieren, indem du einen eigenen Text eingibst und beobachtest, wie das Modell die Input-Daten verarbeitet.

+

+Die Inference API, die dem Widget zugrunde liegt, ist auch als kostenpflichtiges Produkt erhältlich, was recht praktisch ist, wenn du sie für deine Workflows benötigst. Weitere Informationen findest du auf der [Preisseite](https://huggingface.co/pricing).

+

+## Mask Filling

+

+Die nächste Pipeline, die du ausprobieren wirst, ist `fill-mask`. Bei dieser Aufgabe geht es darum, Lücken in einem vorgegebenen Text zu füllen:

+

+```python

+from transformers import pipeline

+

+unmasker = pipeline("fill-mask")

+unmasker("This course will teach you all about models.", top_k=2)

+```

+

+```python out

+[{'sequence': 'This course will teach you all about mathematical models.',

+ 'score': 0.19619831442832947,

+ 'token': 30412,

+ 'token_str': ' mathematical'},

+ {'sequence': 'This course will teach you all about computational models.',

+ 'score': 0.04052725434303284,

+ 'token': 38163,

+ 'token_str': ' computational'}]

+```

+

+Mit dem Argument `top_k` kannst du bestimmen, wie viele Möglichkeiten dir ausgegeben werden sollen. Beachte, dass das Modell hier das spezielle Wort `` auffüllt, das oft als *Mask-Token* bezeichnet wird. Andere Modelle, die dazu dienen, Maskierungen aufzufüllen, können andere Mask Tokens haben. Deshalb ist es immer gut, erst das verwendete Mask Token zu ermitteln, wenn du andere Modelle nutzen möchtest. Eine Möglichkeit, zu überprüfen, welches Mask Token verwendet wird, ist das Widget.

+

+

+

+✏️ **Probiere es aus!** Suche im Hub nach dem Modell `bert-base-cased` und finde sein Mask Token im Widget, das auf der Inference API basiert, heraus. Was sagt dieses Modell für den oben in der Pipeline verwendeten Satz vorher?

+

+

+

+## Named Entity Recognition

+

+Bei der Eigennamenerkennung (engl. Named Entity Recognition, NER) handelt es sich um eine Aufgabenstellung, bei der das Modell herausfinden muss, welche Teile des Input-Textes Entitäten wie Personen, Orte oder Organisationen darstellen. Nehmen wir uns ein konkretes Beispiel zur Hand:

+

+```python

+from transformers import pipeline

+

+ner = pipeline("ner", grouped_entities=True)

+ner("My name is Sylvain and I work at Hugging Face in Brooklyn.")

+```

+

+```python out

+[{'entity_group': 'PER', 'score': 0.99816, 'word': 'Sylvain', 'start': 11, 'end': 18},

+ {'entity_group': 'ORG', 'score': 0.97960, 'word': 'Hugging Face', 'start': 33, 'end': 45},

+ {'entity_group': 'LOC', 'score': 0.99321, 'word': 'Brooklyn', 'start': 49, 'end': 57}

+]

+```

+

+Hier hat das Modell richtig erkannt, dass Sylvain eine Person (PER), Hugging Face eine Organisation (ORG) und Brooklyn ein Ort (LOC) ist.

+

+In der Funktion zur Erstellung der Pipeline übergeben wir die Option `grouped_entities=True`, um die Pipeline anzuweisen, die Teile des Satzes, die der gleichen Entität entsprechen, zu gruppieren: Hier hat das Modell "Hugging" und "Face" richtigerweise als eine einzelne Organisation gruppiert, auch wenn der Name aus mehreren Wörtern besteht. Wie wir im nächsten Kapitel sehen werden, werden bei der Vorverarbeitung (engl. Preprocessing) sogar einige Wörter in kleinere Teile zerlegt. Zum Beispiel wird `Sylvain` in vier Teile zerlegt: `S`, `##yl`, `##va` und `##in`. Im Nachverarbeitungsschritt (engl. Post-Processing) hat die Pipeline diese Teile erfolgreich neu gruppiert.

+

+

+

+✏️ **Probiere es aus!** Suche im Model Hub nach einem Modell, das in der Lage ist, Part-of-Speech-Tagging (in der Regel als POS abgekürzt) im Englischen durchzuführen (Anm.: d. h. Wortarten zuzuordnen). Was sagt dieses Modell für den Satz im obigen Beispiel vorher?

+

+

+

+## Frage-Antwort-Systeme (Question Answering)

+

+Die Pipeline `question-answering` beantwortet Fragen anhand von Informationen, die aus einem bestimmten Kontext stammen:

+

+```python

+from transformers import pipeline

+

+question_answerer = pipeline("question-answering")

+question_answerer(

+ question="Where do I work?",

+ context="My name is Sylvain and I work at Hugging Face in Brooklyn",

+)

+```

+

+```python out

+{'score': 0.6385916471481323, 'start': 33, 'end': 45, 'answer': 'Hugging Face'}

+```

+

+Beachte, dass diese Pipeline Informationen aus dem gegebenen Kontext extrahiert; sie generiert nicht die Antwort.

+

+## Automatische Textzusammenfassung

+

+Bei der automatischen Textzusammenfassung (engl. Summarization) geht es darum, einen Text zu kürzen und dabei alle (oder die meisten) wichtigen Aspekte, auf die im Text verwiesen wird, beizubehalten. Hier ist ein Beispiel:

+

+```python

+from transformers import pipeline

+

+summarizer = pipeline("summarization")

+summarizer(

+ """

+ America has changed dramatically during recent years. Not only has the number of

+ graduates in traditional engineering disciplines such as mechanical, civil,

+ electrical, chemical, and aeronautical engineering declined, but in most of

+ the premier American universities engineering curricula now concentrate on

+ and encourage largely the study of engineering science. As a result, there

+ are declining offerings in engineering subjects dealing with infrastructure,

+ the environment, and related issues, and greater concentration on high

+ technology subjects, largely supporting increasingly complex scientific

+ developments. While the latter is important, it should not be at the expense

+ of more traditional engineering.

+

+ Rapidly developing economies such as China and India, as well as other

+ industrial countries in Europe and Asia, continue to encourage and advance

+ the teaching of engineering. Both China and India, respectively, graduate

+ six and eight times as many traditional engineers as does the United States.

+ Other industrial countries at minimum maintain their output, while America

+ suffers an increasingly serious decline in the number of engineering graduates

+ and a lack of well-educated engineers.

+"""

+)

+```

+

+```python out

+[{'summary_text': ' America has changed dramatically during recent years . The '

+ 'number of engineering graduates in the U.S. has declined in '

+ 'traditional engineering disciplines such as mechanical, civil '

+ ', electrical, chemical, and aeronautical engineering . Rapidly '

+ 'developing economies such as China and India, as well as other '

+ 'industrial countries in Europe and Asia, continue to encourage '

+ 'and advance engineering .'}]

+```

+

+Wie bei der Textgenerierung kannst du eine maximale (`max_length`) oder minimale (`min_length`) Länge für das Ergebnis angeben.

+

+

+## Maschinelle Übersetzung

+

+Für die Maschinelle Übersetzung (engl. Translation) kannst du ein vorgegebenes Standardmodell verwenden, indem du ein Sprachpaar im Aufgabennamen angibst (z. B. `"translation_en_to_fr"`). Am einfachsten ist es jedoch, das Modell, das du verwenden möchtest, im [Model Hub](https://huggingface.co/models) auszuwählen. Im folgenden Beispiel probieren wir die Übersetzung vom Französischen ins Englische aus:

+

+```python

+from transformers import pipeline

+

+translator = pipeline("translation", model="Helsinki-NLP/opus-mt-fr-en")

+translator("Ce cours est produit par Hugging Face.")

+```

+

+```python out

+[{'translation_text': 'This course is produced by Hugging Face.'}]

+```

+

+Wie bei der Textgenerierung und -zusammenfassung kannst du auch hier `max_length` oder `min_length` als Argumente für das Ergebnis angeben.

+

+

+

+✏️ **Probiere es aus!** Suche nach Übersetzungsmodellen in anderen Sprachen und versuche, den vorangegangenen Satz in mehrere verschiedene Sprachen zu übersetzen.

+

+

+

+Die bisher gezeigten Pipelines dienen hauptsächlich zu Demonstrationszwecken. Sie wurden für bestimmte Aufgabenstellungen programmiert und sind nicht für Abwandlungen geeignet. Im nächsten Kapitel erfährst du, was sich hinter einer `pipeline()`-Funktion verbirgt und wie du ihr Verhalten anpassen kannst.

diff --git a/chapters/de/chapter1/4.mdx b/chapters/de/chapter1/4.mdx

new file mode 100644

index 000000000..c9641aa31

--- /dev/null

+++ b/chapters/de/chapter1/4.mdx

@@ -0,0 +1,176 @@

+# Wie funktionieren Transformer-Modelle?

+

+

+

+In diesem Abschnitt werfen wir einen Blick auf die Architektur von Transformer-Modellen.

+

+## Kurz zur Entwicklungsgeschichte der Transformer-Modelle

+

+Hier sind einige wichtige Meilensteine in der (kurzen) Geschichte der Transformer-Modelle:

+

+

+

+Die [🤗 Transformers-Bibliothek](https://github.com/huggingface/transformers) bietet die Funktionalität, um diese geteilten Modelle zu erstellen und zu nutzen. Der [Model Hub](https://huggingface.co/models) enthält Tausende von vortrainierten Modellen, die jeder herunterladen und nutzen kann. Auch du kannst dort deine eigenen Modelle hochladen!

+

+

+⚠️ Der Hugging Face Hub ist nicht auf Transformer-Modelle beschränkt. Jede bzw. jeder kann die von ihr bzw. ihm gewünschten Arten von Modellen oder Datensätzen teilen! Erstelle ein Konto auf huggingface.co, um alle verfügbaren Features nutzen zu können!

+

+

+Bevor wir uns ansehen, wie Transformer-Modelle im Einzelnen funktionieren, widmen wir uns ein paar Beispielen, die veranschaulichen, wie sie zur Lösung interessanter CL-Problemstellungen eingesetzt werden können.

+

+## Mit Pipelines arbeiten

+

+

+

+Das grundlegendste Objekt in der 🤗 Transformers-Bibliothek ist die `pipeline()`-Funktion. Sie verbindet ein Modell mit den notwendigen Vor- und Nachverarbeitungsschritten (engl. Preprocessing/Postprocessing) und ermöglicht es uns, direkt einen beliebigen Text eingeben zu können und eine Antwort zu erhalten, die verständlich ist:

+

+```python

+from transformers import pipeline

+

+classifier = pipeline("sentiment-analysis")

+classifier("I've been waiting for a HuggingFace course my whole life.")

+```

+

+```python out

+[{'label': 'POSITIVE', 'score': 0.9598047137260437}]

+```

+

+Wir können sogar mehrere Sätze auf einmal übergeben!

+

+```python

+classifier(

+ ["I've been waiting for a HuggingFace course my whole life.", "I hate this so much!"]

+)

+```

+

+```python out

+[{'label': 'POSITIVE', 'score': 0.9598047137260437},

+ {'label': 'NEGATIVE', 'score': 0.9994558095932007}]

+```

+

+In der Voreinstellung wählt diese Pipeline ein bestimmtes vortrainiertes Modell aus, das bereits für die Sentiment-Analyse in englischer Sprache feingetunt wurde. Wenn du das `classifier`-Objekt erstellst, wird das Modell heruntergeladen und zwischengespeichert. Wenn du den Befehl erneut ausführst, wird stattdessen das zwischengespeicherte Modell verwendet und das Modell muss nicht erneut heruntergeladen werden.

+

+Wenn du einen Text an eine Pipeline übergibst, gibt es drei wichtige Schritte:

+

+1. Der Text wird im Rahmen der Vorverarbeitung in ein Format überführt, das das Modell verstehen kann.

+2. Die vorverarbeiteten Inputs bzw. Eingaben werden an das Modell übergeben.

+3. Die Vorhersagen des Modells werden so nachverarbeitet, sodass du sie nutzen kannst.

+

+

+Einige der derzeit [verfügbaren Pipelines](https://huggingface.co/transformers/main_classes/pipelines.html) sind:

+

+- `feature-extraction` (Vektordarstellung eines Textes erhalten)

+- `fill-mask`

+- `ner` (Named Entity Recognition)

+- `question-answering`

+- `sentiment-analysis`

+- `summarization`

+- `text-generation`

+- `translation`

+- `zero-shot-classification`

+

+Werfen wir doch gleich mal einen Blick auf ein paar von ihnen!

+

+## Zero-Shot-Klassifizierung

+

+Beginnen wir mit der recht anspruchsvollen Aufgabe, Texte zu klassifizieren, die noch nicht gelabelt wurden. Dieses Problem tritt häufig in realen Projekten auf, da das Labeln von Texten in der Regel zeitaufwendig ist und Fachwissen erfordert. Für diesen Anwendungsfall ist die Pipeline `zero-shot-classification` sehr vielversprechend: Mit ihr kannst du festlegen, welche Labels für die Klassifizierung verwendet werden sollen, und musst nicht auf die Labels des vortrainierten Modells zurückgreifen. Wie du bereits gesehen hast, kann das Modell einen Satz - entsprechend der beiden Labels - als positiv oder negativ klassifizieren. Es kann den Text aber auch auf der Grundlage einer beliebigen anderen Auswahl an Labels klassifizieren.

+

+```python

+from transformers import pipeline

+

+classifier = pipeline("zero-shot-classification")

+classifier(

+ "This is a course about the Transformers library",

+ candidate_labels=["education", "politics", "business"],

+)

+```

+

+```python out

+{'sequence': 'This is a course about the Transformers library',

+ 'labels': ['education', 'business', 'politics'],

+ 'scores': [0.8445963859558105, 0.111976258456707, 0.043427448719739914]}

+```

+

+Diese Pipeline heißt _zero-shot_, weil du das Modell nicht erst auf deine Daten feintunen musst, ehe du es verwenden kannst. Sie kann direkt die Wahrscheinlichkeiten für jede beliebige von dir vorgegebene Liste von Labels liefern!

+

+

+

+✏️ **Probiere es aus!** Spiel mit deinen eigenen Sequenzen und Labels herum und beobachte, wie sich das Modell verhält.

+

+

+

+

+## Textgenerierung

+

+Sehen wir uns nun an, wie du eine Pipeline verwenden kannst, wenn du einen Text generieren möchtest. Der Grundgedanke dabei ist, dass du einen bestimmten Input (einen sog. Prompt) vorgibst und das Modell diesen automatisch vervollständigt, indem es den restlichen Text generiert. Das ist ähnlich wie die Textvorhersagefunktion, die auf vielen Handys zu finden ist. Die Textgenerierung erfolgt nach dem Zufallsprinzip - daher ist es normal, wenn du nicht die gleichen Ergebnisse wie die unten gezeigten erhältst.

+

+```python

+from transformers import pipeline

+

+generator = pipeline("text-generation")

+generator("In this course, we will teach you how to")

+```

+

+```python out

+[{'generated_text': 'In this course, we will teach you how to understand and use '

+ 'data flow and data interchange when handling user data. We '

+ 'will be working with one or more of the most commonly used '

+ 'data flows — data flows of various types, as seen by the '

+ 'HTTP'}]

+```

+

+Mit dem Argument `num_return_sequences` kannst du steuern, wie viele verschiedene Sequenzen erzeugt werden und mit dem Argument `max_length`, wie lang der Ausgabetext insgesamt sein soll.

+

+

+

+✏️ **Probiere es aus!** Wähle die Argumente `num_return_sequences` und `max_length` so, dass zwei Sätze mit jeweils 15 Wörtern erzeugt werden.

+

+

+

+

+## Verwendung eines beliebigen Modells vom Hub in einer Pipeline

+

+In den vorherigen Beispielen wurde für die jeweilige Aufgabe das voreingestellte Standardmodell verwendet. Du kannst aber auch ein bestimmtes Modell aus dem Hub auswählen und es in einer Pipeline für eine konkrete Aufgabe verwenden - zum Beispiel für die Textgenerierung. Gehe zum [Model Hub](https://huggingface.co/models) und klicke auf der linken Seite unter `Tasks` auf das entsprechende Tag, um dir lediglich die für diese Aufgabenstellung unterstützten Modelle anzeigen zu lassen. Du solltest anschließend auf eine Seite wie [diese](https://huggingface.co/models?pipeline_tag=text-generation) gelangen.

+

+Probieren wir nun das Modell [`distilgpt2`](https://huggingface.co/distilgpt2) aus! So kannst du es mit der gleichen Pipeline wie zuvor laden:

+

+```python

+from transformers import pipeline

+

+generator = pipeline("text-generation", model="distilgpt2")

+generator(

+ "In this course, we will teach you how to",

+ max_length=30,

+ num_return_sequences=2,

+)

+```

+

+```python out

+[{'generated_text': 'In this course, we will teach you how to manipulate the world and '

+ 'move your mental and physical capabilities to your advantage.'},

+ {'generated_text': 'In this course, we will teach you how to become an expert and '

+ 'practice realtime, and with a hands on experience on both real '

+ 'time and real'}]

+```

+

+Du kannst deine Suche nach einem Modell verfeinern, indem du auf eines der `Languages`-Tags klickst und ein Modell auswählst, das Text in einer anderen Sprache generiert. Der Model Hub enthält sogar Checkpoints für mehrsprachige Modelle, die mehrere verschiedene Sprachen unterstützen.

+

+Nachdem du auf ein Modell geklickt und es ausgewählt hast, siehst du, dass es ein Widget gibt, mit dem du es direkt online ausprobieren kannst. Dementsprechend kannst du die Fähigkeiten eines Modells erst schnell testen, bevor du dich dazu entschließt, es herunterzuladen.

+

+

+

+✏️ **Probiere es aus!** Verwende die Filter, um ein Textgenerierungsmodell für eine andere Sprache zu finden. Experimentiere ruhig ein wenig mit dem Widget und verwende das Modell in einer Pipeline!

+

+

+

+### Die Inference API

+

+Alle Modelle können direkt über deinen Browser getestet werden, indem du die Inference API verwendest, die auf der [Webseite von Hugging Face](https://huggingface.co/) verfügbar ist. Auf dieser Seite kannst du direkt mit dem Modell experimentieren, indem du einen eigenen Text eingibst und beobachtest, wie das Modell die Input-Daten verarbeitet.

+

+Die Inference API, die dem Widget zugrunde liegt, ist auch als kostenpflichtiges Produkt erhältlich, was recht praktisch ist, wenn du sie für deine Workflows benötigst. Weitere Informationen findest du auf der [Preisseite](https://huggingface.co/pricing).

+

+## Mask Filling

+

+Die nächste Pipeline, die du ausprobieren wirst, ist `fill-mask`. Bei dieser Aufgabe geht es darum, Lücken in einem vorgegebenen Text zu füllen:

+

+```python

+from transformers import pipeline

+

+unmasker = pipeline("fill-mask")

+unmasker("This course will teach you all about models.", top_k=2)

+```

+

+```python out

+[{'sequence': 'This course will teach you all about mathematical models.',

+ 'score': 0.19619831442832947,

+ 'token': 30412,

+ 'token_str': ' mathematical'},

+ {'sequence': 'This course will teach you all about computational models.',

+ 'score': 0.04052725434303284,

+ 'token': 38163,

+ 'token_str': ' computational'}]

+```

+

+Mit dem Argument `top_k` kannst du bestimmen, wie viele Möglichkeiten dir ausgegeben werden sollen. Beachte, dass das Modell hier das spezielle Wort `` auffüllt, das oft als *Mask-Token* bezeichnet wird. Andere Modelle, die dazu dienen, Maskierungen aufzufüllen, können andere Mask Tokens haben. Deshalb ist es immer gut, erst das verwendete Mask Token zu ermitteln, wenn du andere Modelle nutzen möchtest. Eine Möglichkeit, zu überprüfen, welches Mask Token verwendet wird, ist das Widget.

+

+

+

+✏️ **Probiere es aus!** Suche im Hub nach dem Modell `bert-base-cased` und finde sein Mask Token im Widget, das auf der Inference API basiert, heraus. Was sagt dieses Modell für den oben in der Pipeline verwendeten Satz vorher?

+

+

+

+## Named Entity Recognition

+

+Bei der Eigennamenerkennung (engl. Named Entity Recognition, NER) handelt es sich um eine Aufgabenstellung, bei der das Modell herausfinden muss, welche Teile des Input-Textes Entitäten wie Personen, Orte oder Organisationen darstellen. Nehmen wir uns ein konkretes Beispiel zur Hand:

+

+```python

+from transformers import pipeline

+

+ner = pipeline("ner", grouped_entities=True)

+ner("My name is Sylvain and I work at Hugging Face in Brooklyn.")

+```

+

+```python out

+[{'entity_group': 'PER', 'score': 0.99816, 'word': 'Sylvain', 'start': 11, 'end': 18},

+ {'entity_group': 'ORG', 'score': 0.97960, 'word': 'Hugging Face', 'start': 33, 'end': 45},

+ {'entity_group': 'LOC', 'score': 0.99321, 'word': 'Brooklyn', 'start': 49, 'end': 57}

+]

+```

+

+Hier hat das Modell richtig erkannt, dass Sylvain eine Person (PER), Hugging Face eine Organisation (ORG) und Brooklyn ein Ort (LOC) ist.

+

+In der Funktion zur Erstellung der Pipeline übergeben wir die Option `grouped_entities=True`, um die Pipeline anzuweisen, die Teile des Satzes, die der gleichen Entität entsprechen, zu gruppieren: Hier hat das Modell "Hugging" und "Face" richtigerweise als eine einzelne Organisation gruppiert, auch wenn der Name aus mehreren Wörtern besteht. Wie wir im nächsten Kapitel sehen werden, werden bei der Vorverarbeitung (engl. Preprocessing) sogar einige Wörter in kleinere Teile zerlegt. Zum Beispiel wird `Sylvain` in vier Teile zerlegt: `S`, `##yl`, `##va` und `##in`. Im Nachverarbeitungsschritt (engl. Post-Processing) hat die Pipeline diese Teile erfolgreich neu gruppiert.

+

+

+

+✏️ **Probiere es aus!** Suche im Model Hub nach einem Modell, das in der Lage ist, Part-of-Speech-Tagging (in der Regel als POS abgekürzt) im Englischen durchzuführen (Anm.: d. h. Wortarten zuzuordnen). Was sagt dieses Modell für den Satz im obigen Beispiel vorher?

+

+

+

+## Frage-Antwort-Systeme (Question Answering)

+

+Die Pipeline `question-answering` beantwortet Fragen anhand von Informationen, die aus einem bestimmten Kontext stammen:

+

+```python

+from transformers import pipeline

+

+question_answerer = pipeline("question-answering")

+question_answerer(

+ question="Where do I work?",

+ context="My name is Sylvain and I work at Hugging Face in Brooklyn",

+)

+```

+

+```python out

+{'score': 0.6385916471481323, 'start': 33, 'end': 45, 'answer': 'Hugging Face'}

+```

+

+Beachte, dass diese Pipeline Informationen aus dem gegebenen Kontext extrahiert; sie generiert nicht die Antwort.

+

+## Automatische Textzusammenfassung

+

+Bei der automatischen Textzusammenfassung (engl. Summarization) geht es darum, einen Text zu kürzen und dabei alle (oder die meisten) wichtigen Aspekte, auf die im Text verwiesen wird, beizubehalten. Hier ist ein Beispiel:

+

+```python

+from transformers import pipeline

+

+summarizer = pipeline("summarization")

+summarizer(

+ """

+ America has changed dramatically during recent years. Not only has the number of

+ graduates in traditional engineering disciplines such as mechanical, civil,

+ electrical, chemical, and aeronautical engineering declined, but in most of

+ the premier American universities engineering curricula now concentrate on

+ and encourage largely the study of engineering science. As a result, there

+ are declining offerings in engineering subjects dealing with infrastructure,

+ the environment, and related issues, and greater concentration on high

+ technology subjects, largely supporting increasingly complex scientific

+ developments. While the latter is important, it should not be at the expense

+ of more traditional engineering.

+

+ Rapidly developing economies such as China and India, as well as other

+ industrial countries in Europe and Asia, continue to encourage and advance

+ the teaching of engineering. Both China and India, respectively, graduate

+ six and eight times as many traditional engineers as does the United States.

+ Other industrial countries at minimum maintain their output, while America

+ suffers an increasingly serious decline in the number of engineering graduates

+ and a lack of well-educated engineers.

+"""

+)

+```

+

+```python out

+[{'summary_text': ' America has changed dramatically during recent years . The '

+ 'number of engineering graduates in the U.S. has declined in '

+ 'traditional engineering disciplines such as mechanical, civil '

+ ', electrical, chemical, and aeronautical engineering . Rapidly '

+ 'developing economies such as China and India, as well as other '

+ 'industrial countries in Europe and Asia, continue to encourage '

+ 'and advance engineering .'}]

+```

+

+Wie bei der Textgenerierung kannst du eine maximale (`max_length`) oder minimale (`min_length`) Länge für das Ergebnis angeben.

+

+

+## Maschinelle Übersetzung

+

+Für die Maschinelle Übersetzung (engl. Translation) kannst du ein vorgegebenes Standardmodell verwenden, indem du ein Sprachpaar im Aufgabennamen angibst (z. B. `"translation_en_to_fr"`). Am einfachsten ist es jedoch, das Modell, das du verwenden möchtest, im [Model Hub](https://huggingface.co/models) auszuwählen. Im folgenden Beispiel probieren wir die Übersetzung vom Französischen ins Englische aus:

+

+```python

+from transformers import pipeline

+

+translator = pipeline("translation", model="Helsinki-NLP/opus-mt-fr-en")

+translator("Ce cours est produit par Hugging Face.")

+```

+

+```python out

+[{'translation_text': 'This course is produced by Hugging Face.'}]

+```

+

+Wie bei der Textgenerierung und -zusammenfassung kannst du auch hier `max_length` oder `min_length` als Argumente für das Ergebnis angeben.

+

+

+

+✏️ **Probiere es aus!** Suche nach Übersetzungsmodellen in anderen Sprachen und versuche, den vorangegangenen Satz in mehrere verschiedene Sprachen zu übersetzen.

+

+

+

+Die bisher gezeigten Pipelines dienen hauptsächlich zu Demonstrationszwecken. Sie wurden für bestimmte Aufgabenstellungen programmiert und sind nicht für Abwandlungen geeignet. Im nächsten Kapitel erfährst du, was sich hinter einer `pipeline()`-Funktion verbirgt und wie du ihr Verhalten anpassen kannst.

diff --git a/chapters/de/chapter1/4.mdx b/chapters/de/chapter1/4.mdx

new file mode 100644

index 000000000..c9641aa31

--- /dev/null

+++ b/chapters/de/chapter1/4.mdx

@@ -0,0 +1,176 @@

+# Wie funktionieren Transformer-Modelle?

+

+

+

+In diesem Abschnitt werfen wir einen Blick auf die Architektur von Transformer-Modellen.

+

+## Kurz zur Entwicklungsgeschichte der Transformer-Modelle

+

+Hier sind einige wichtige Meilensteine in der (kurzen) Geschichte der Transformer-Modelle:

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+Note that a list of [project ideas](https://discuss.huggingface.co/c/course/course-event/25) is also available on the forums if you wish to practice more once you have completed the course.

+

+- **Where can I get the code for the course?**

+For each section, click on the banner at the top of the page to run the code in either Google Colab or Amazon SageMaker Studio Lab:

+

+

+

+Note that a list of [project ideas](https://discuss.huggingface.co/c/course/course-event/25) is also available on the forums if you wish to practice more once you have completed the course.

+

+- **Where can I get the code for the course?**

+For each section, click on the banner at the top of the page to run the code in either Google Colab or Amazon SageMaker Studio Lab:

+

+ +

+The Jupyter notebooks containing all the code from the course are hosted on the [`huggingface/notebooks`](https://github.com/huggingface/notebooks) repo. If you wish to generate them locally, check out the instructions in the [`course`](https://github.com/huggingface/course#-jupyter-notebooks) repo on GitHub.

+

+

+- **How can I contribute to the course?**

+There are many ways to contribute to the course! If you find a typo or a bug, please open an issue on the [`course`](https://github.com/huggingface/course) repo. If you would like to help translate the course into your native language, check out the instructions [here](https://github.com/huggingface/course#translating-the-course-into-your-language).

+

+- ** What were the choices made for the each translation?**

+Each translation has a glossary and `TRANSLATING.txt` file that details the choices that were made for machine learning jargon etc. You can find an example for German [here](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Can I reuse this course?**

+Of course! The course is released under the permissive [Apache 2 license](https://www.apache.org/licenses/LICENSE-2.0.html). This means that you must give appropriate credit, provide a link to the license, and indicate if changes were made. You may do so in any reasonable manner, but not in any way that suggests the licensor endorses you or your use. If you would like to cite the course, please use the following BibTeX:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed ]"

+}

+```

+

Are you ready to roll? In this chapter, you will learn:

+

* How to use the `pipeline()` function to solve NLP tasks such as text generation and classification

* About the Transformer architecture

* How to distinguish between encoder, decoder, and encoder-decoder architectures and use cases

+

diff --git a/chapters/es/_toctree.yml b/chapters/es/_toctree.yml

index 24519d9e3..6289440b6 100644

--- a/chapters/es/_toctree.yml

+++ b/chapters/es/_toctree.yml

@@ -35,6 +35,10 @@

title: Manejando Secuencias Múltiples

- local: chapter2/6

title: Poniendo todo junto

+ - local: chapter2/7

+ title: ¡Haz completado el uso básico!

+ - local: chapter2/8

+ title: Quiz de final de capítulo

- title: 3. Ajuste (fine-tuning) de un modelo preentrenado

sections:

diff --git a/chapters/es/chapter2/7.mdx b/chapters/es/chapter2/7.mdx

new file mode 100644

index 000000000..6d7c470c3

--- /dev/null

+++ b/chapters/es/chapter2/7.mdx

@@ -0,0 +1,18 @@

+# ¡Haz completado el uso básico!

+

+

+

+¡Buen trabajo siguiendo el curso hasta ahora! Para recapitular, en este capítulo tú:

+

+- Aprendiste los bloques de construcción básicos de un modelo Transformer.

+- Aprendiste lo que compone a un pipeline de tokenización.

+- Viste cómo usar un modelo Transformer en la práctica.

+- Aprendiste cómo aprovechar un tokenizador para convertir texto a tensores que sean entendibles por el modelo.

+- Configuraste un tokenizador y un modelo juntos para pasar dle texto a predicciones.

+- Aprendiste las limitaciones de los IDs de entrada, y aprendiste acerca de máscaras de atención.

+- Jugaste con los métodos del tokenizador versátiles y configurables.

+

+A partir de ahora, serás capaz de navegar libremente por la documentación de 🤗 Transformers: el vocabulario te sonará familiar, ya que has visto los métodos que usarás la mayor parte del tiempo.

diff --git a/chapters/es/chapter2/8.mdx b/chapters/es/chapter2/8.mdx

new file mode 100644

index 000000000..b935571c7

--- /dev/null

+++ b/chapters/es/chapter2/8.mdx

@@ -0,0 +1,310 @@

+

+

+

+

+# Quiz de final de capítulo

+

+

+

+### 1. ¿Cuál es el orden del pipeline de modelado del lenguaje?

+

+

+

+### 2. ¿Cuántas dimensiones tiene el tensor producido por el modelo base de Transformer y cuáles son?

+

+

+

+### 3. ¿Cuál de los siguientes es un ejemplo de tokenización de subpalabras?

+

+

+

+### 4. ¿Qué es una cabeza del modelo?

+

+

+

+{#if fw === 'pt'}

+### 5. ¿Qué es un AutoModel?

+

+AutoTrain?"

+ },

+ {

+ text: "Un objeto que devuelve la arquitectura correcta basado en el punto de control",

+ explain: "Exacto: el

+

+The Jupyter notebooks containing all the code from the course are hosted on the [`huggingface/notebooks`](https://github.com/huggingface/notebooks) repo. If you wish to generate them locally, check out the instructions in the [`course`](https://github.com/huggingface/course#-jupyter-notebooks) repo on GitHub.

+

+

+- **How can I contribute to the course?**

+There are many ways to contribute to the course! If you find a typo or a bug, please open an issue on the [`course`](https://github.com/huggingface/course) repo. If you would like to help translate the course into your native language, check out the instructions [here](https://github.com/huggingface/course#translating-the-course-into-your-language).

+

+- ** What were the choices made for the each translation?**

+Each translation has a glossary and `TRANSLATING.txt` file that details the choices that were made for machine learning jargon etc. You can find an example for German [here](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Can I reuse this course?**

+Of course! The course is released under the permissive [Apache 2 license](https://www.apache.org/licenses/LICENSE-2.0.html). This means that you must give appropriate credit, provide a link to the license, and indicate if changes were made. You may do so in any reasonable manner, but not in any way that suggests the licensor endorses you or your use. If you would like to cite the course, please use the following BibTeX:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed ]"

+}

+```

+

Are you ready to roll? In this chapter, you will learn:

+

* How to use the `pipeline()` function to solve NLP tasks such as text generation and classification

* About the Transformer architecture

* How to distinguish between encoder, decoder, and encoder-decoder architectures and use cases

+

diff --git a/chapters/es/_toctree.yml b/chapters/es/_toctree.yml

index 24519d9e3..6289440b6 100644

--- a/chapters/es/_toctree.yml

+++ b/chapters/es/_toctree.yml

@@ -35,6 +35,10 @@

title: Manejando Secuencias Múltiples

- local: chapter2/6

title: Poniendo todo junto

+ - local: chapter2/7

+ title: ¡Haz completado el uso básico!

+ - local: chapter2/8

+ title: Quiz de final de capítulo

- title: 3. Ajuste (fine-tuning) de un modelo preentrenado

sections:

diff --git a/chapters/es/chapter2/7.mdx b/chapters/es/chapter2/7.mdx

new file mode 100644

index 000000000..6d7c470c3

--- /dev/null

+++ b/chapters/es/chapter2/7.mdx

@@ -0,0 +1,18 @@

+# ¡Haz completado el uso básico!

+

+

+

+¡Buen trabajo siguiendo el curso hasta ahora! Para recapitular, en este capítulo tú:

+

+- Aprendiste los bloques de construcción básicos de un modelo Transformer.

+- Aprendiste lo que compone a un pipeline de tokenización.

+- Viste cómo usar un modelo Transformer en la práctica.

+- Aprendiste cómo aprovechar un tokenizador para convertir texto a tensores que sean entendibles por el modelo.

+- Configuraste un tokenizador y un modelo juntos para pasar dle texto a predicciones.

+- Aprendiste las limitaciones de los IDs de entrada, y aprendiste acerca de máscaras de atención.

+- Jugaste con los métodos del tokenizador versátiles y configurables.

+

+A partir de ahora, serás capaz de navegar libremente por la documentación de 🤗 Transformers: el vocabulario te sonará familiar, ya que has visto los métodos que usarás la mayor parte del tiempo.

diff --git a/chapters/es/chapter2/8.mdx b/chapters/es/chapter2/8.mdx

new file mode 100644

index 000000000..b935571c7

--- /dev/null

+++ b/chapters/es/chapter2/8.mdx

@@ -0,0 +1,310 @@

+

+

+

+

+# Quiz de final de capítulo

+

+

+

+### 1. ¿Cuál es el orden del pipeline de modelado del lenguaje?

+

+

+

+### 2. ¿Cuántas dimensiones tiene el tensor producido por el modelo base de Transformer y cuáles son?

+

+

+

+### 3. ¿Cuál de los siguientes es un ejemplo de tokenización de subpalabras?

+

+

+

+### 4. ¿Qué es una cabeza del modelo?

+

+

+

+{#if fw === 'pt'}

+### 5. ¿Qué es un AutoModel?

+

+AutoTrain?"

+ },

+ {

+ text: "Un objeto que devuelve la arquitectura correcta basado en el punto de control",

+ explain: "Exacto: el AutoModel sólo necesita conocer el punto de control desde el cual inicializar para devolver la arquitectura correcta.",

+ correct: true

+ },

+ {

+ text: "Un modelo que detecta automáticamente el lenguaje usado por sus entradas para cargar los pesos correctos",

+ explain: "Incorrecto; auqneu algunos puntos de control y modelos son capaced de manejar varios lenguajes, no hay herramientas integradas para la selección automática de punto de control de acuerdo al lenguaje. ¡Deberías dirigirte a Model Hub para encontrar el mejor punto de control para tu tarea!"

+ }

+ ]}

+/>

+

+{:else}

+### 5. ¿Qué es un TFAutoModel?

+

+AutoTrain?"

+ },

+ {

+ text: "Un objeto que devuelve la arquitectura correcta basado en el punto de control",

+ explain: "Exacto: el TFAutoModel sólo necesita conocer el punto de control desde el cual inicializar para devolver la arquitectura correcta.",

+ correct: true

+ },

+ {

+ text: "Un modelo que detecta automáticamente el lenguaje usado por sus entradas para cargar los pesos correctos",

+ explain: "Incorrecto; auqneu algunos puntos de control y modelos son capaced de manejar varios lenguajes, no hay herramientas integradas para la selección automática de punto de control de acuerdo al lenguaje. ¡Deberías dirigirte a Model Hub para encontrar el mejor punto de control para tu tarea!"

+ }

+ ]}

+/>

+

+{/if}

+

+### 6. ¿Cuáles son las técnicas a tener en cuenta al realizar batching de secuencias de diferentes longitudes juntas?

+

+

+

+### 7. ¿Cuál es el punto de aplicar una funcion SoftMax a las salidas logits por un modelo de clasificación de secuencias?

+

+

+

+### 8. ¿En qué método se centra la mayor parte de la API del tokenizador?

+

+encode, ya que puede codificar texto en IDs e IDs en predicciones",

+ explain: "¡Incorrecto! Aunque el método encode existe en los tokenizadores, no existe en los modelos."

+ },

+ {

+ text: "Llamar al objeto tokenizador directamente.",

+ explain: "¡Exactamente! El método __call__ del tokenizador es un método muy poderoso el cual puede manejar casi cualquier cosa.También es el método usado para recuperar las predicciones de un modelo.",

+ correct: true

+ },

+ {

+ text: "pad",

+ explain: "¡Incorrecto! El relleno es muy útil, pero es solo una parte de la API tokenizador."

+ },

+ {

+ text: "tokenize",

+ explain: "El método tokenize es posiblemente uno de los métodos más útiles, pero no es el núcleo de la API tokenizador."

+ }

+ ]}

+/>

+

+### 9. ¿Qué contiene la variable `result` en este código de ejemplo?

+

+```py

+from transformers import AutoTokenizer

+

+tokenizer = AutoTokenizer.from_pretrained("bert-base-cased")

+result = tokenizer.tokenize("Hello!")

+```

+

+__call__ o convert_tokens_to_ids!"

+ },

+ {

+ text: "Una cadena que contiene todos los tokens",

+ explain: "Esto sería subóptimo, ya que el objetivo es dividir la cadena en varios tokens."

+ }

+ ]}

+/>

+

+{#if fw === 'pt'}

+### 10. ¿Hay algo mal con el siguiente código?

+

+```py

+from transformers import AutoTokenizer, AutoModel

+

+tokenizer = AutoTokenizer.from_pretrained("bert-base-cased")

+model = AutoModel.from_pretrained("gpt2")

+

+encoded = tokenizer("Hey!", return_tensors="pt")

+result = model(**encoded)

+```

+

+

+

+{:else}

+### 10. ¿Hay algo mal con el siguiente código?

+

+```py

+from transformers import AutoTokenizer, TFAutoModel

+

+tokenizer = AutoTokenizer.from_pretrained("bert-base-cased")

+model = TFAutoModel.from_pretrained("gpt2")

+

+encoded = tokenizer("Hey!", return_tensors="pt")

+result = model(**encoded)

+```

+

+

+

+{/if}

diff --git a/utils/generate_notebooks.py b/utils/generate_notebooks.py

index 781fb19b3..d7f235243 100644

--- a/utils/generate_notebooks.py

+++ b/utils/generate_notebooks.py

@@ -21,6 +21,9 @@

frameworks = {"pt": "PyTorch", "tf": "TensorFlow"}

PATH_TO_COURSE = Path("chapters/")

+# Languages to exlude from the notebook generation because the notebooks were

+# created manually

+LANGS_TO_EXCLUDE = ["fr"]

def read_and_split_frameworks(fname):

@@ -277,6 +280,8 @@ def create_notebooks(language, output_dir):

languages = [f.stem for f in PATH_TO_COURSE.iterdir() if f.is_dir()]

for language in languages:

+ if language in LANGS_TO_EXCLUDE:

+ continue

language_output_dir = f"{args.output_dir}/{language}"

create_notebooks(language, language_output_dir)

# Remove empty notebook folders

+

+Wenn du nach dem Kurs noch weiter üben möchtest, steht dir in den Foren eine Liste mit [Projektideen](https://discuss.huggingface.co/c/course/course-event/25) zur Verfügung.

+

+- **Wo finde ich den Code für den Kurs?**

+In jedem Abschnitt kannst du auf das oben auf der Seite befindliche Banner klicken, um den Code entweder in Google Colab oder in Amazon SageMaker Studio Lab auszuführen:

+

+

+

+Wenn du nach dem Kurs noch weiter üben möchtest, steht dir in den Foren eine Liste mit [Projektideen](https://discuss.huggingface.co/c/course/course-event/25) zur Verfügung.

+

+- **Wo finde ich den Code für den Kurs?**

+In jedem Abschnitt kannst du auf das oben auf der Seite befindliche Banner klicken, um den Code entweder in Google Colab oder in Amazon SageMaker Studio Lab auszuführen:

+

+ +

+Die Jupyter-Notebooks, die den gesamten Code des Kurses enthalten, befinden sich im [`huggingface/notebooks`-Repo](https://github.com/huggingface/notebooks). Wenn du sie lokal aufsetzen möchtest, schau dir die Anweisungen im [`course`-Repository](https://github.com/huggingface/course#-jupyter-notebooks) auf GitHub an.

+

+

+- **Wie kann ich etwas zum Kurs beitragen?**

+Es gibt mehrere Möglichkeiten, zum Kurs beizutragen! Wenn du einen Tippfehler oder einen Fehler entdeckst, eröffne bitte ein Issue in dem [`course`-Repository](https://github.com/huggingface/course). Wenn du uns dabei unterstützen möchtest, den Kurs in deine Muttersprache zu übersetzen, sieh dir bitte die [Anleitung](https://github.com/huggingface/course#translating-the-course-into-your-language) an.

+

+- **Welche Entscheidungen wurden bei den einzelnen Übersetzungen getroffen?**

+Für jede Übersetzung gibt es ein Glossar und die Datei `TRANSLATING.txt`, in der die gewählten Fachtermini usw. festgehalten sind. Ein Beispiel für die deutsche Fassung findest du [hier](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Kann ich diesen Kurs auch an anderer Stelle verwenden?**

+Ja, natürlich! Der Kurs ist unter der permissiven [Apache-2-Lizenz](https://www.apache.org/licenses/LICENSE-2.0.html) veröffentlicht. Das bedeutet, dass du den Kurs in angemessener Weise erwähnen, einen Verweis zur Lizenz angeben und darauf hinweisen musst, wenn du Änderungen vorgenommen hast. Du kannst dies in jeder angemessenen Weise tun, allerdings nicht in einer Weise, die den Eindruck erweckt, dass der Lizenzgeber dich oder deine Nutzung unterstützt. Wenn du den Kurs zitieren möchtest, verwende bitte den folgenden BibTeX-Eintrag:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed

+

+Die Jupyter-Notebooks, die den gesamten Code des Kurses enthalten, befinden sich im [`huggingface/notebooks`-Repo](https://github.com/huggingface/notebooks). Wenn du sie lokal aufsetzen möchtest, schau dir die Anweisungen im [`course`-Repository](https://github.com/huggingface/course#-jupyter-notebooks) auf GitHub an.

+

+

+- **Wie kann ich etwas zum Kurs beitragen?**

+Es gibt mehrere Möglichkeiten, zum Kurs beizutragen! Wenn du einen Tippfehler oder einen Fehler entdeckst, eröffne bitte ein Issue in dem [`course`-Repository](https://github.com/huggingface/course). Wenn du uns dabei unterstützen möchtest, den Kurs in deine Muttersprache zu übersetzen, sieh dir bitte die [Anleitung](https://github.com/huggingface/course#translating-the-course-into-your-language) an.

+

+- **Welche Entscheidungen wurden bei den einzelnen Übersetzungen getroffen?**

+Für jede Übersetzung gibt es ein Glossar und die Datei `TRANSLATING.txt`, in der die gewählten Fachtermini usw. festgehalten sind. Ein Beispiel für die deutsche Fassung findest du [hier](https://github.com/huggingface/course/blob/main/chapters/de/TRANSLATING.txt).

+

+

+- **Kann ich diesen Kurs auch an anderer Stelle verwenden?**

+Ja, natürlich! Der Kurs ist unter der permissiven [Apache-2-Lizenz](https://www.apache.org/licenses/LICENSE-2.0.html) veröffentlicht. Das bedeutet, dass du den Kurs in angemessener Weise erwähnen, einen Verweis zur Lizenz angeben und darauf hinweisen musst, wenn du Änderungen vorgenommen hast. Du kannst dies in jeder angemessenen Weise tun, allerdings nicht in einer Weise, die den Eindruck erweckt, dass der Lizenzgeber dich oder deine Nutzung unterstützt. Wenn du den Kurs zitieren möchtest, verwende bitte den folgenden BibTeX-Eintrag:

+

+```

+@misc{huggingfacecourse,

+ author = {Hugging Face},

+ title = {The Hugging Face Course, 2022},

+ howpublished = "\url{https://huggingface.co/course}",

+ year = {2022},

+ note = "[Online; accessed  +

+ +

+Note that a list of [project ideas](https://discuss.huggingface.co/c/course/course-event/25) is also available on the forums if you wish to practice more once you have completed the course.

+

+- **Where can I get the code for the course?**

+For each section, click on the banner at the top of the page to run the code in either Google Colab or Amazon SageMaker Studio Lab:

+

+

+

+Note that a list of [project ideas](https://discuss.huggingface.co/c/course/course-event/25) is also available on the forums if you wish to practice more once you have completed the course.

+

+- **Where can I get the code for the course?**

+For each section, click on the banner at the top of the page to run the code in either Google Colab or Amazon SageMaker Studio Lab:

+

+ +

+The Jupyter notebooks containing all the code from the course are hosted on the [`huggingface/notebooks`](https://github.com/huggingface/notebooks) repo. If you wish to generate them locally, check out the instructions in the [`course`](https://github.com/huggingface/course#-jupyter-notebooks) repo on GitHub.

+

+

+- **How can I contribute to the course?**